Здравствуйте, уважаемые читатели блога KtoNaNovenkogo.ru. Находясь на начальном этапе познания поисковой оптимизации, многие маркетологи и будущие SEO-специалисты сталкиваются со шквалом разнородной информации, которую поначалу трудно упорядочить и структурировать.

Каким аспектам SEO стоит уделить внимание в первую очередь? С чего начать оптимизацию сайта? Как провести первичный технический аудит и обработать полученную информацию? Ответы на эти и многие другие вопросы вы найдёте в данной статье.

1. Инструкции по индексации

Настройка инструкций для поисковых роботов — едва ли не первое, с чем приходится разбираться каждому начинающему специалисту, и однозначно первое, в чём допускается основная масса фатальных ошибок, препятствующих поисковому продвижению сайта.

В числе наиболее распространённых промахов можно назвать следующие:

- от индексации закрыты страницы, которые должны быть проиндексированы и потенциально могут приносить трафик;

- от индексации закрыты файлы, влияющие на внешний вид страницы;

- от индексации закрыты страницы, на которые выставлен перманентный редирект, или которые указаны в качестве канонических;

- выставлен атрибут rel=nofollow для ссылок на внутренние страницы, за счёт чего теряется часть ссылочного веса.

Определить, какие инструкции выставлены на страницах внутри вашего сайта, и нет ли каких-то проблем, связанных с неправильным указанием директив robots.txt, Meta Robots или X-Robots-Tag, можно при помощи краулера. Мы будем использовать в качестве инструмента для проведения SEO-аудита Netpeak Spider.

Итак, для анализа поисковых директив нужно сделать следующее:

- Запустите Netpeak Spider.

- Откройте в основном меню «Настройки» → «Основные».

- Установите настройки по умолчанию.

- Чтобы убедиться, что файлы .js и .css не закрыты от индексации, включите проверку JavaScript и CSS.

- Сохраните настройки и вернитесь к основному окну программы.

- Перейдите к боковой панели и откройте вкладку «Параметры».

- Убедитесь, что все параметры в пункте «Индексация» включены.

- Введите адрес сайта в строку «Начальный URL» и запустите сканирование.

По итогу сканирования вы сможете получить детализированную информацию несколькими путями:

- Таблица с информацией по всем просканированным URL.

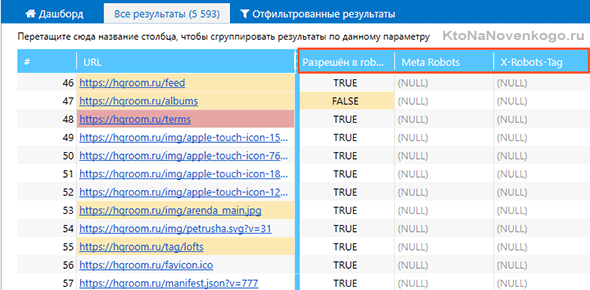

По итогу сканирования перед вами предстанет таблица с полным списком просканированных страниц. В столбце «Разрешён в robots.txt» вы увидите, не закрыт ли каждый отдельный URL от индексации, а в столбцах «Meta Robots» и «X-Robots-Tag» будут указаны применённые к данному URL директивы.

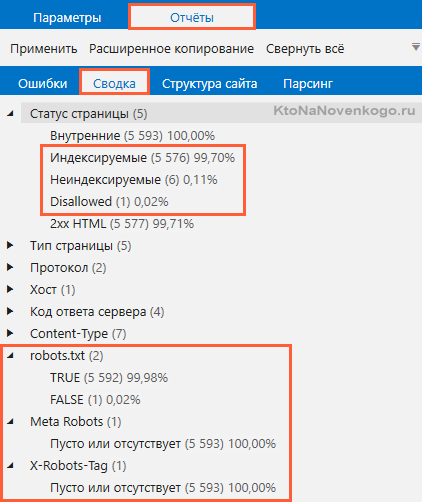

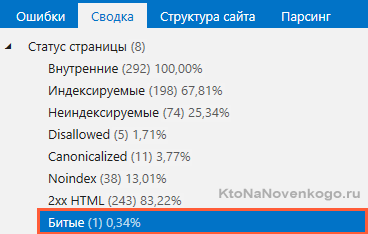

- Вкладка «Сводка» («Отчёты») на боковой панели.

Выбрав интересующий вас признак, которому соответствуют те или иные страницы, вы отфильтруете результаты сканирования, сосредоточившись исключительно на тех URL, для которых в robots.txt прописан Disallow, или, к примеру, на которых выставлен nofollow, noindex при помощи Meta Robots или X-Robots-Tag.

- Вкладка «Ошибки («Отчёты») на боковой панели.

На основании результатов сканирования программа определяет несколько десятков типов ошибок, в том числе — ошибки (предупреждения), связанные с инструкциями для индексации. - Дашборд с данными о статусе индексируемости.

На вкладке «Дашборд» по соседству с таблицей результатов сканирования информация об индексируемых и неиндексируемых страницах сайта будет представлена в виде круговой диаграммы. Там же можно будет найти диаграмму, наглядно демонстрирующую причины неиндексируемости. Каждый из сегментов диаграммы кликабелен и действует по аналогии с фильтрацией, которая была описана выше.

2. Метатеги Title и Description

Оптимизация метатегов Title и Description — один из важнейших этапов поисковой оптимизации сайта. Во-первых, их содержимое тщательно анализируется поисковыми роботами для составления общего представления о содержимом страницы. Во-вторых, именно они формируют сниппет страницы в поисковой выдаче.

В разрезе SEO-аудита сайта необходимо проанализировать:

- на всех ли страницах есть Title и Description;

- из скольких символов состоят Title (не менее 10 и не более 70 символов в среднем) и Description (не менее 50 и не более 260-320 символов);

- нет ли дублей, Title и Description внутри сайта;

- не присутствует ли на странице сразу несколько Title и Description.

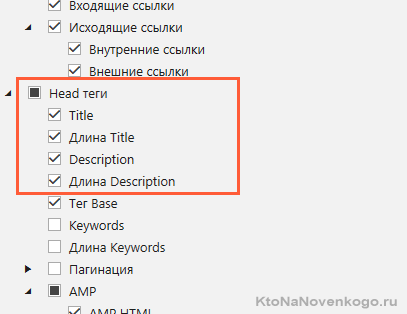

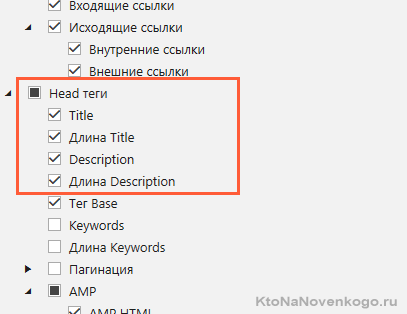

Чтобы выяснить, как обстоит ситуация с данными метатегами в рамках вашего сайта, обязательно отметьте на боковой панели параметры «Title», «длина Title», «Description» и «длина Description».

К слову, если вам нужно, чтобы Title и Description были строго определённой длины, вы можете задать диапазон допустимых значений в разделе «Настройки» → «Ограничения».

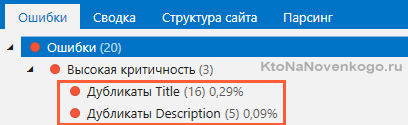

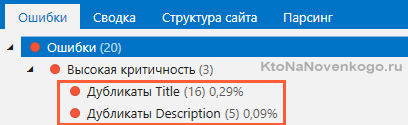

В процессе сканирования программа определит длину каждого из метатегов, а на вкладке с ошибками укажет все имеющиеся проблемы Title и Description.

3. XML-карта сайта

Прежде чем приступить к проверке карты сайта, ответьте себе на два вопроса:

- Есть ли на анализируемом сайте XML-карта сайта?

- Если да, то указан ли её адрес в файле robots.txt?

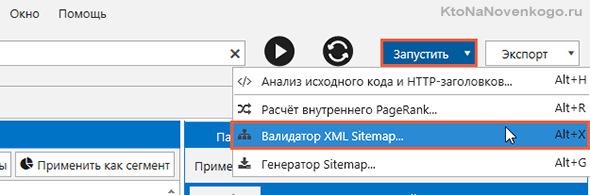

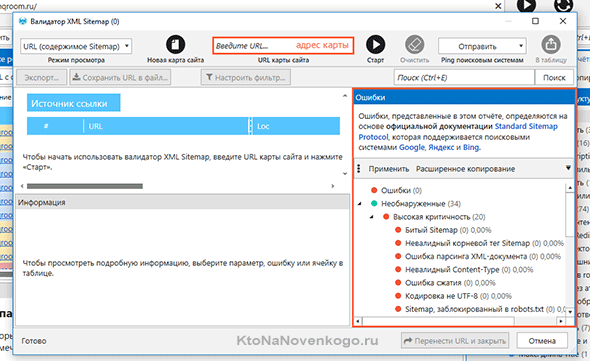

Если ответ на оба вопроса «да», специалисту, осуществляющему аудит, остаётся только одно: проанализировать карту на наличие разного рода ошибок. Лучше всего делать это при помощи встроенного в Netpeak Spider инструмента «Валидатор XML Sitemap». Для запуска проверки вам нужно:

- Запустить Netpeak Spider.

- В правом верхнем углу нажать «Запустить» → «Валидатор XML Sitemap».

- Ввести адрес карты и нажать «Старт» для запуска.

*при клике по картинке она откроется в полный размер в новом окне - Дождаться окончания сканирования и ознакомиться со списком найденных ошибок на боковой панели. Все включённые в карту сайта страницы, на которых были найдены ошибки, можно перенести в основную таблицу, нажав кнопку «Перенести URL и закрыть».

4. Время ответа сервера

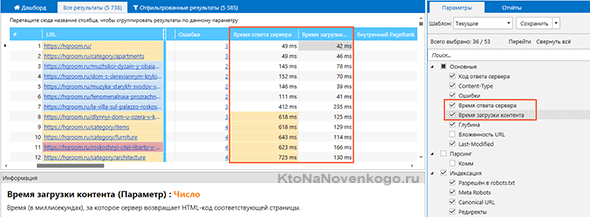

Чем быстрее ваш сайт работает, тем лучше. Это касается скорости ответа сервера, который должен максимально быстро откликнуться на запрос, отправленный вашим браузером, а также скорости загрузки самого контента.

Для анализа обоих показателей мы воспользуемся краулером. Процедура сканирования производится по аналогии с той, что мы описывали выше: главное — не забыть отметить параметры «Время ответа сервера» и «Время загрузки контента» перед стартом анализа.

*при клике по картинке она откроется в полный размер в новом окне

По окончанию сканирования слишком медленные страницы будут отмечены как страницы с ошибкой средней критичности «Большое время ответа сервера».

5. Дубликаты

Полное или частичное дублирование контента внутри сайта, пусть даже ненамеренное, может существенно осложнить путь вашего сайта к вершинам органической поисковой выдачи. Поисковые системы крайне негативно реагируют на дубли, так что в рамках SEO-аудита вам следует обратить внимание на все основные виды дублей внутри своего сайта для их последующего устранения.

Сканируя сайт в Netpeak Spider, вы сможете обнаружить полные дубликаты страницы, а также дубликаты метатегов Title и Description (мы уже говорили о них в параграфе 2), заголовков H1 и текстового содержимого.

6. Контент

Грамотно оптимизированное содержимое страницы должно включать в себя:

- грамотный и уникальный текст объёмом не менее 500 символов;

- один основной заголовок первого порядка H1;

- оптимизированные изображения с прописанным атрибутом ALT.

Если у вас есть чёткое понимание того, в каких рамках может варьироваться вес изображений, размер H1 и объём текста, их можно задать вручную в разделе «Настройки» → «Ограничения».

Чтобы проверить каждый из указанных выше аспектов, следует:

- Запустить Netpeak Spider.

- В списке параметров на боковой панели обязательно отметить:

- «Контент» → «Изображения»;

- «Заголовки H1-H6» → «Содержимое H1», «Длина H1», «заголовки H1»;

- «Показатели» → «Размер контента».

Если вы хотите вдобавок проверить сайт (раздел сайта, список страниц) на предмет наличия подзаголовков H2 и H3, отметьте соответствующие параметры в пункте «Заголовки H1-H6».

- Ввести адрес сайта и запустить сканирование.

- После завершения процедуры в основной таблице с результатами сканирования вы увидите столбцы с данными по объёму контента, а также — по длине H1. На боковой панели на вкладке «Отчёты» → «Ошибки» высветятся ошибки, связанные с оптимизацией контента, включая проблемы с заголовками H1, размером контента и отсутствием атрибута ALT у изображений.

Списки URL, содержащих одну (или более) из ошибок выше, можно отфильтровать и выгрузить в виде отдельного отчёта.

7. Битые ссылки

Существует множество неоднозначных факторов поисковой оптимизации, относительно которых в экспертной среде нет однозначного мнения. Однако битые ссылки (ссылки, отдающие 404 код ответа сервера) точно не относятся к их числу: все опытные специалисты в один голос твердят об их крайне пагубном на оптимизацию сайта.

Поиск битых ссылок — процедура, которую вам предстоит выполнять на регулярной основе, а не только в рамках глобального первичного SEO-аудита.

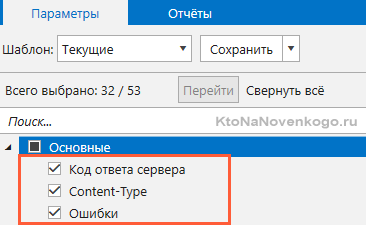

Для анализа сайта на предмет поиска битых ссылок достаточно будет активировать всего три параметра: «Код ответа сервера», «Content-Type», «Ошибки».

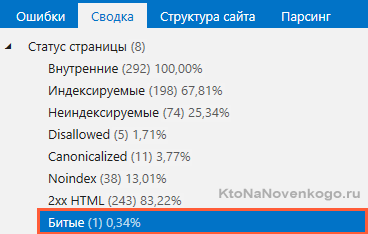

По итогу сканирования вы сможете найти все страницы, отдающие 404 ошибку, в основной таблице с результатами сканирования (напротив них будет указан соответствующий код ответа сервера), на панели «Сводка», а также в списке страниц, отфильтрованных по ошибкам «Битые ссылки» и «Битые изображения».

8. Редиректы

Установки перенаправлений, или редиректов, — обязательный этап оптимизации любого сайта. Редиректы помогают бороться с дубликатами и направлять пользователей на нужные страницы в случае перехода на уже несуществующие URL.

Важно помнить о том, что выставленный на постоянной основе редирект должен отдавать исключительно 301 (не 302) код ответа, а также не должен вести на страницу с дальнейшей переадресацией. Также не забывайте, что для успешной индексации целевой страницы поисковыми роботами она не должна быть закрыта при помощи robots.txt, Meta Robots или X-Robots-Tag.

Таким образом, в числе основных проблем, связанных с переадресацией, можно назвать следующие:

- Битый редирект (перенаправление на недоступную или несуществую страницу).

- Бесконечный редирект (перенаправление с текущей страницы на саму себя).

- Максимальное количество редиректов (более 4 редиректов в последовательности по умолчанию).

- Редирект, заблокированный в robots.txt.

- Редиректы с неправильным форматом URL (перенаправление с неправильным форматом URL в HTTP-заголовках ответа сервера).

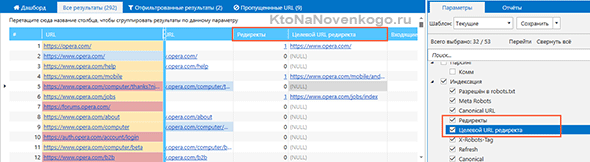

В процессе проведения технического аудита вы сможете выявить на вашем сайте все вышеупомянутые проблемы, а также проконтролировать корректность указания конечных URL для переадресации.

*при клике по картинке она откроется в полный размер в новом окне

9. Атрибут rel=canonical

Не исключено, что на подходе к девятому пункту вам на миг могло показаться, что всё самое важное уже осталось позади. Однако до тех пор, пока в чеклист SEO-аудита не включён анализ атрибута Canonical, его нельзя считать полноценным. Какие же проблемы могут быть связаны с неправильной настройкой Canonical?

- цепочка Canonical;

- Canonical, заблокированный в robots.txt (иными словами, приоритетная для индексации страница отдаёт код ответа, отличный от 200 OK).

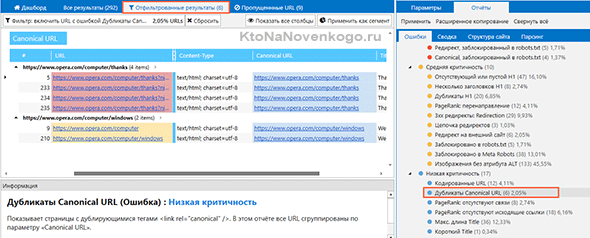

Также не стоит забывать о вероятности того, что какие-то из атрибутов были выставлены по ошибке, а потому не позволяют как следует индексироваться важным страницам вашего сайта. Чтобы проконтролировать этот аспект оптимизации, мы рекомендуем воспользоваться фильтрацией по таким ошибкам (предупреждениям низкой критичности) Netpeak Spider, как «Неканонические страницы» и «Дубликаты Canonical URL».

Первая показывает неканонические страницы, у которых URL в теге указывает на другую страницу, вторая показывает страницы с дублирующимися тегами <link rel=»canonical» /> (при использовании этого фильтра все URL будут сгруппированы по параметру «Canonical URL»).

*при клике по картинке она откроется в полный размер в новом окне

10. Смешанный контент

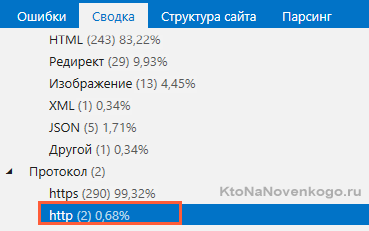

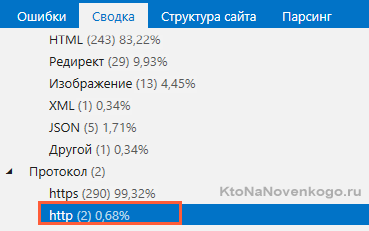

Если ранее вы совершили попытку «переезда» на безопасный протокол HTTPS, но не настроили сайт необходимым образом, вы столкнётесь с таким понятием как «смешанный контент». Оно означает, что на сайте одновременно есть страницы с безопасным и небезопасным протоколом. Чтобы проверить, относится ли это и к вашему сайту, запустите сканирование с параметрами по умолчанию.

Список страниц, протокол которых не изменился после переезда на HTTPS, можно будет найти на боковой панели на вкладке «Сводка».

Также они будут подсвечены как страницы с ошибкой (низкая критичность) «Не HTTPS-протокол».

Коротко о главном

Чтобы провести базовый технический SEO-аудит сайта перед началом работы над новым проектом, включите в него проверку нескольких основных пунктов:

- Проверка инструкций по индексации,

- Проверка правильности заполнения Meta Title и Meta Description,

- Валидация XML-карты сайта,

- Анализ времени ответа сервера,

- Поиск дубликатов,

- Проверка оптимизации контента,

- Проверка сайта на наличие битых ссылок,

- Проверка выставленных редиректов,

- Проверка атрибута rel=canonical,

- Поиск смешанного контента, возникшего при попытке переезда на HTTPS-протокол.

Для анализа вам понадобится краулер, в качестве которого мы использовали Netpeak Spider. который определит все ключевые проблемы сайта для их последующего устранения.

P.S. Для читателей блога действует специальная скидка на покупку лицензий Netpeak Spider – 10%. Чтобы её использовать, на этапе оплаты введите промокод 8018e2e0

Удачи вам! До скорых встреч на страницах блога KtoNaNovenkogo.ru

Подборки по теме

Использую для заработка